目前的主流机器翻译进路,哪里出了错?

随着人工智能在最近几年的蓬勃发展,作为人工智能子课题的“机器翻译”(machine translation)研究也日益受到市场与社会的重视。目前谷歌、百度、搜狗等国内外著名网络搜索公司都提供了相应的在线自动翻译服务,译文的质量也正与日提升。

不过,与某些业界人士的狂热态度不同,笔者并不对机器翻译现有技术路径的未来发展前

途抱有盲目的乐观态度。这不仅是因为目前机器翻译平台所提供的译文在质量上还远远没有达到可以“取代职业人类译员”的水平,更是因为:目前在机器翻译界中备受宠爱的“深度学习”技术,主要是作为一种“工程学技巧”进入我们的视野的。实际上,我们目前尚无法在科学层面上清楚地说明:“深度学习”技术为何能够提高相关程序之应用表现——遑论在哲学层面上为这种“进步”的“可持续性”提供辩护。相反,从哲学角度看,我们依然可以通过提出如下一个问题,来怀疑“基于深度学习的自动翻译技术”是否能够真正地“理解”人类语言:这个问题的文献出处是柏拉图的《美诺篇》。在柏拉图的笔下,一个从未学过几何学的小奴隶在苏格拉底的指导下学会了几何证明。由此引发的问题是:小奴隶的“心智机器”,究竟是如何可能在“学习样本缺乏”的情况下获取有关于几何学证明的技能的呢?而后世的语言学家乔姆斯基则沿着柏拉图的思路,问出了一个类似的问题:0-3岁的婴幼儿是如何在语料刺激相对贫乏的情况下,学会复杂的人类语法的?

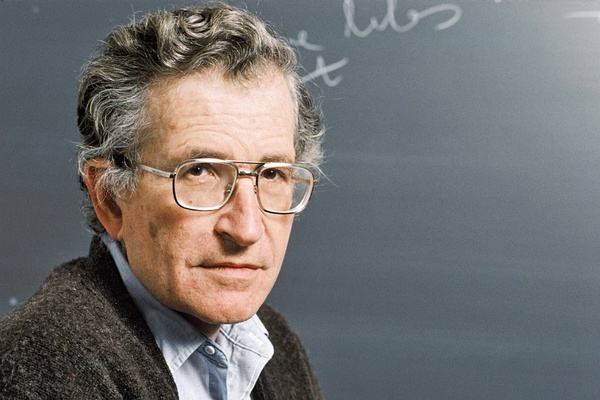

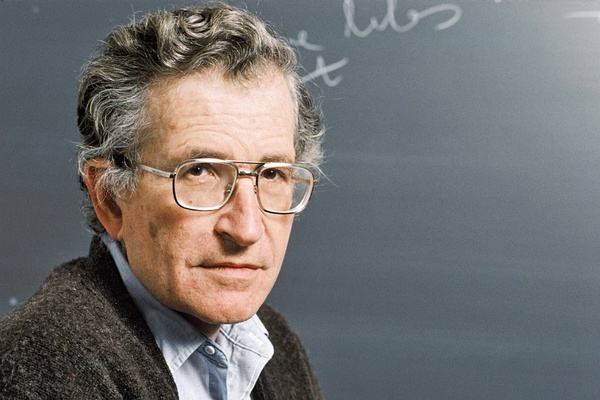

诺姆·乔姆斯基

——换言之,按照柏拉图—乔姆斯基的看法,任何一种对于人类语言能力的建模方案,如果无法具备对于“刺激的贫乏性”(the poverty of stimuli)的容忍性的话,那么相关的建模成果就不能被说成是具备对于人类语言的理解能力的。

若按照这样的标准去衡量,我们是否可以认为目前基于深度学习的机器翻译技术是能够理解人类语言的呢?答案是否定的。实际上,已经有专家指出,目前的深度学习机制所需要的训练样本的数量应当是“谷歌级别”的——换言之,小样本的输入往往会导致参数复杂的系统产生“过度拟合”(overfitting)的问题(也就是说,系统一旦适应了初始的小规模训练样本中的某些特设性特征,就无法灵活地处理与训练数据不同的新数据)换言之,无论基于深度学习技术的机器翻译系统已经通过多大的训练量完成了与既有数据的“拟合”,只要新输入的数据与旧数据之间的表面差距足够大,“过度拟合”的幽灵就都一直会在附近徘徊。

上述对于主流深度学习翻译路径的批评意见,非常容易将我们导向那种基于乔姆斯基生成语言研究的“基于规则的机器翻译”思路——因为在乔姆斯基派的学者看来,只有基于“句法驱动”(而不是“数据驱动”)的翻译机制才可能完美应对“刺激的贫乏性”问题所提出的挑战。然而,从“数据驱动的机器翻译机制无法解决‘刺激的贫乏性问题’”这一相对正确的前提出发,我们是得不出“我们只能拥抱句法驱动机制”这一结论的(换言之,乔姆斯基学派只是提出了“对的问题”而已——它们却没有给出“对的答案”)。