-

1 视频

-

2 章节测验

认知语言学的“具身性”对于人工智能伦理学的启示

我们已经看到,伦理规范自身是很难摆脱“具身性”的规制的;其次,我们却发现阿西莫夫式的机器伦理编制工作却既没有意识到“具身性”的重要性,同时也缺乏一个使得其自身的语义内容得以落地的语义学基础理论。而要将这里所说的具身性考量与语义学考量结合起来,我们就需要一个合适的理论媒介。这一媒介就是认知语言学。

之所以要提到认知语言学,乃是因为它提供了一个将前面所提到的“具身性原则”与语义学理论相互结合的范例。认知语言学的代表人物之一雷考夫(George Lakoff)就曾概括过认知语义学的意义观与传统意义观之间的不同。

认知语言学提出了很多技术概念,一非常具有代表性的技术概念是“认知图式”(cognitiveschema)。

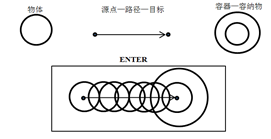

“图式”一词的古希腊词源“σχήμα”有“形状”的意思,而在认知语言学的语境中,“图式”指的则是指“一系列语例中的共通性在得到强化后所获得的一些抽象的模板”[6]P.23。在认识语言学中,此类“抽象模板”往往是按照“意像式”(imagistic)的方式来加以把握——而所谓的“意像式”结构,本身乃是“前概念”的,是具有一定的“可视性”的。譬如,英语“ENTER”(进入)这个概念就可以被分析为数个意象图式的组合,包括“物体”(object)、“源点—路径—目标”(source-path-goal)与“容器—容纳物”(container-content)。三者结合的情况如图—1所示:

图—1 关于“ENTER”的认知图式形成过程的图示

这样的“可视化”图式当然包含了明确的身体指涉。说得更清楚一点,这样的概念图示预设了概念的使用者具有这样的身体经验:自主移动身体,从一个源点出发,沿着一定的路径,进入一个“容器”,并由此使得自己成为一个“容纳物”。换言之,一个从来没有移动过自己的身体,甚至从来没有观察到其它物体之移动的语言处理系统,恐怕是无法真正把握“ENTER”的图式,并由此真正把握“进入”这个概念的含义的。

而在从属于“图式”的各个“图式要素”中,“辖域”(scope)这个术语亦与“具身性”有着密切的关联。在认知语言学的语境中,“辖域”指的是一个目标概念在被聚焦时,语用主体的注意力在语义网中所能够覆盖的周遭范围——其中与核心区域较近的周遭范围叫“直接辖域”,而注意力的最大范围边界便是“最大辖域”。譬如,对于“肘部”这个概念来说,其直接辖域就是“胳膊”,而其最大辖域就是“身体”;而对于“铰链”这个概念来说,“门”就是其直接辖域,而“房屋”则是其最大辖域。而之所以说基于“辖域”的认知语言学叙述方式体现了“具身性”的要素,乃是因为:任何“辖域”的存在均是有赖于其边界的存在,而任何“辖域”的边界的存在又有赖于认知主体的视野的范围的大小,而认知主体的视野的范围的大小则最终又取决于其身体的特性。换言之,“辖域”的特征归根结蒂还是为认知主体的身体特性所塑造的。

首先可以肯定的是,伦理学所研究的社会规范本身往往就带有“身体图式”的印记。让我们不妨来想想在周遭社会中所遇到的种种社会规范所具有的语言表达吧!——“这是军事禁地!禁止入内!”(这个表达预设了关于“进入”的身体图式);“行车时不能挤占公交车道!”(这个表达预设了“挤占”这个概念的身体图式);“不许占据别人的财物”(这个表达式预设了“占据”是一个将原离身体的非辖域转化为其近侧辖域的动态过程);“不许杀人”(这个表达式预设了被涉及到的人类身体的确具有终止别的人类身体的生物学机能的物理能力)。不难想见,如果上述这些关于身体图式的预设全部被抽空的话,那么我们就很可能会凭空造出一些让人不知所云的社会规范,如“永远不能挤占银河系之外的空间!”、“永远都不能通过吐口水的方式来淹死长颈鹿”,等等。这也就从认知语言学的角度印证了汉密尔顿—麦金泰尔路线的伦理学研究思路,即:伦理学规范的内容是某种生物学需要的或直接或间接的再包装,而不是脱离了这些需要的纯精神臆造物。

而上述的研究思路一旦被推广到人工智能伦理学——尤其是机器伦理学——领域内,就会立即触发如下的问题:既然没有任何科学方面的理由使得“小人国”或“大人国”尺度上的智能机器人无法被制造出来,那么,我们又如何保证这样的机器人所具有的“认知图式”会与人类的“认知图式”彼此合拍呢?而如果这种“合拍性”无法被保证的话,我们又如何保证同样建立在机器人自身身体图式之上的机器人的伦理规范能够与人类既有的伦理规范相合拍呢?而如果后一种“合拍性”也无法被保证的话,我们又如何保证这样的智能机器人不会对人类既有的社会秩序构成威胁呢?

未来机器人设计的身体维度——道德编码的核心

为了使得笔者所表达的上述疑虑不显得那么空洞,我在此还想就此表达两个补充性意见。

其一,在笔者看来,任何的智能机器人——如果其具有真正意义上的全面智能的话——所具有的语言智能,都应当包括对于身体图式的识解能力。之所以如此判断,则是基于如下推理:机器人所使用的符号若要与外部环境产生有效的、富有灵活性的互动的话,它们就必须对使用特定符号的典型语境有所把握,而身体图式恰恰是浓缩了此类典型语境信息的最佳推理中介。因此,认知语言学家关于人类认知图式的很多理论,至少就其哲学精神而言是适用于未来的人工智能体的——至于如何找到合适的编程手段来体现认知语言学的原则,则是另外一个话题了。

第二条补充意见:如果两类智能体(无论是人造的还是自然的)在身体图式上存在着时—空尺度上的巨大差异的话,那么这两个话语体系之间的转译成本就会显得非常巨大,甚至有时会变得不可转译。这一观察对于伦理规范编制的直接影响就是:机器人很可能会因为无法识解人类伦理规范所隐藏的身体图式,而无法识解整条规范。退一步讲,如果这些机器人的语言智能的发达程度已经达到了允许其通过内部的类比推理来间接把握人类身体图式的地步,那么,它们由此所理解的人类社会规范对其而言也只具有一种抽象的意义,因为这样的规范实在离它们自己的“生活形式”太远。在此情况下,我们就很难指望这样的智能机器人会严肃地对待人类的社会规范,并在此基础上成为人类所期望的工作与生活中的有用的帮手。

基于以上的讨论,在笔者看来,为了防止种种对人类不利的情况的出现,机器伦理学家就必须预先阻止“完整意义上的语义智能”与“与人类的时空尺度迥然不同的身体构造”这两项因素在同一个机器人身上的结合。而要做到这一点,从逻辑上看,我们就只有三个选项:

选项一:我们姑且可以去建造与我们人类的时空尺度迥异的机器人,但是不赋予其高级语义智能,即不赋予其在复杂环境下独立、灵活地作出决策的能力。

选项二:在我们将人类意义上的灵活智能赋予机器人的时候,必须要保证其身体界面与人类的身体界面没有时空尺度与性能表现上的重大差异——或说得更清楚一点,这样的机器人不能比人类跑得快太多或强悍太多,但也不能比人类慢太多或脆弱太多。甚至我们要鼓励更多的人型机器人的开发,使得机器人与人类之间能够形成基于“身体上的彼此承认”的“共情感”。套用麦金泰尔式的“需要伦理学”的话语框架,我们也可以这么说:我们必须在硬件构造上就使得机器人产生对于其它机器人特别是人类的“需要”,就像人类社会中的任何一个成员在生物学意义上就需要他人才能够生存一样。

选项三:我们可以将富有灵活智能的机器人与比较“愚笨”的机器人临时地组合起来,让前者去临时地操控后者,就像我们人类自己也会临时地去操控相对缺乏自主智能的机械一样。但需要注意的是,我们切不可将这两类机器人的临时组合长久化以催生某种对人类不利的新的认知图式,就像我们人类自己也只能在特殊情况下才允许人类士兵去使用真枪实弹一样。

当然,除了以上三个选项之外,笔者也不排除:在某种特殊情况下,我们将不得不将“完整意义上的语义智能”与“与人类的时空尺度迥然不同的身体构造”这两项因素予以永久性的结合。但即使如此,我们也至少要保证此类机器人与主流人类社会没有广泛的空间接触,以此维护人类社会的安全。

如果用一句话来概括笔者的论点的话,那便是:太聪明的人工智能并不构成对于人类的威胁——毋宁说,太聪明的人工智能与超强的外围硬件设备的恒久组合形式,才会构成对于人类的威胁,因为与人类迥异的身体图式本身就会塑造出一个与人类不同的语义网络,并由此使得人类的传统道德规范很难附着于其上。基于此推理,人工智能伦理学的研究方向就应当“由软转硬”,即从对于软件编制的规范的探讨,转向研究“怎样的外围硬件才允许与人工智能的中央处理器进行接驳”这一崭新的问题。