配置hosts列表

-

1 2022G大数据

-

2

上一节

下一节

配置hostname

(1)在192.168.1.4这台主机执行

hostnamectl set-hostname master

(2)在192.168.1.6这台主机执行

hostnamectl set-hostname worker1

(3)在192.168.1.7这台主机执行

hostnamectl set-hostname worker2

通过hostname查看是否设置成功

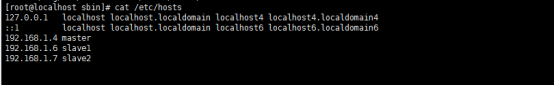

配置hosts

(1)在192.168.1.4这台主机执行

vi /etc/hosts

添加以下内容

192.168.1.4 master

192.168.1.6 worker1

192.168.1.7 worker2

(2)在192.168.1.6这台主机执行

vi /etc/hosts

添加以下内容

192.168.1.4 master

192.168.1.6 worker1

192.168.1.7 worker2

(3)在192.168.1.7这台主机执行

vi /etc/hosts

添加以下内容

192.168.1.4 master

192.168.1.6 worker1

192.168.1.7 worker2